Netty 入门 — 什么是 Netty?

一、BIO、NIO、AIO

学习 Netty 需要了解 BIO、NIO、AIO,具体可参考

二、什么是 Netty?

官网介绍

Netty is an asynchronous event-driven network application frameworkfor rapid development of maintainable high performance protocol servers & clients.

Netty 是 一个异步事件驱动的网络应用程序框架,用于快速开发可维护的高性能协议服务器和客户端。

Netty 是一个 NIO 客户端服务器框架,可以快速轻松地开发协议服务器和客户端等网络应用程序。它极大地简化和流线了网络编程,例如 TCP 和 UDP 套接字服务器。

“快速和简单”并不意味着生成的应用程序会受到可维护性或性能问题的影响。Netty 是经过精心设计的,它借鉴了许多协议(如 FTP、SMTP、HTTP 以及各种基于二进制和基于文本的遗留协议)的实现经验。因此,Netty 成功地找到了一种方法,可以在不妥协的情况下实现易于开发、性能、稳定性和灵活性。

三、为什么学习 Netty?

Netty 在 NIO 的基础上进行了封装,比 NIO 强大,Netty 使用很广泛,用的企业多,所以需要去学习,Netty 支持高并发,在高并发的情况下具有良好的吞吐量,是网络通讯的首选框架

四、原生 NIO 存在的问题

-

NIO 的类库和 API 繁杂,使用麻烦,需要熟练掌握 Selector、ServerSocketChannel、SocketChannel、ByteBuffer 等

-

需要具备其他额外技能,要熟悉 Java 多线程编程,因为 NIO 编程涉及到 Reactor 模式,你必须对多线程和网络编程非常熟悉,才能编写出高质量的 NIO 程序

-

开发工作量和难度都非常大,例如客户端面临断连重连、网络闪断、半包读写,失败缓存、网络拥塞和异常流的处理等

-

JDK NIO 的 Bug:例如臭名昭著的 Epoll Bug,它会导致 Selector 空轮询,最终导致 CPU100%,直到 JDK1.7 版本该问题仍旧存在,没有被根本解决

五、Netty 有什么好处

Netty 对 JDK 自带的 NIO 的 API 进行了封装,解决了上述问题

-

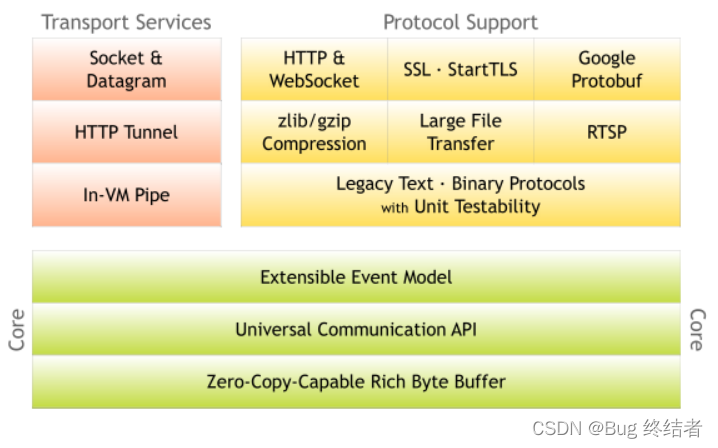

设计优雅,适用于各种传输类型的统一 API 阻塞和非阻塞 Socket,基于灵活且可扩展的事件模型,可以清晰地分离关注点,高度可定制的线程模型 – 单线程,一个或多个线程池

-

使用方便,详细记录的 JavaDoc,用户指南和示例,没有其它依赖项,JDK5(Netty3.x)或 6(Netty4.x)就可以

-

安全,完整的 SSL/TLS 和 StartTLS 支持

-

社区活跃,不断更新;版本迭代周期短,发现的 Bug 可以被及时修复,同时,更多的新功能会被加入

-

更高的吞吐量,更低的延迟

-

更少的资源消耗

-

最小化不必要的内存拷贝

Netty 模型图

六、那些领域用到了 Netty

Netty 在互联网领域、大数据分布式计算领域、游戏行业、通信行业等获得了广泛的应用,一些业界著名的开源组件也基于 Netty 的 NIO 框架构建 (文章尾有详细介绍)。 2.Netty 的特点 高并发 Netty 是一款基于 NIO(Nonblocking IO,非阻塞 IO)开发的网络通信框架,对比于 BIO(Blocking IO,阻塞 IO),他的并发性能得到了很大提高 。

七、Netty 模型

♨️简单版本

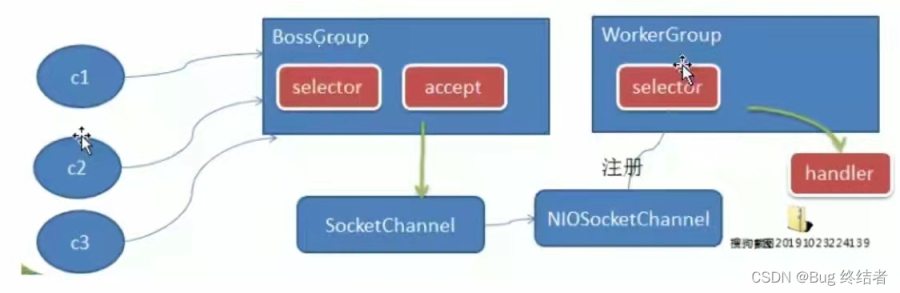

工作原理示意图-简单版

Netty 主要基于主从 Reactor 多线程模型,做了一定的改进,其中主从 Reactor 多线程有多个 Reactor

对上图说明

-

BoosGroup 线程维护 Selector,只关注 Accept

-

当接受到 Accept 事件,获取到对应的 SocketChannel,封装成 NIOSocketChannel 并注册到 Worker 线程(事件循环),并进行维护

-

当 Worker 线程监听到 selector 中通道发生自己感兴趣的事件后,就进行处理(就由 Handler),注意 handler 已经加入通道。

♨️进阶版本

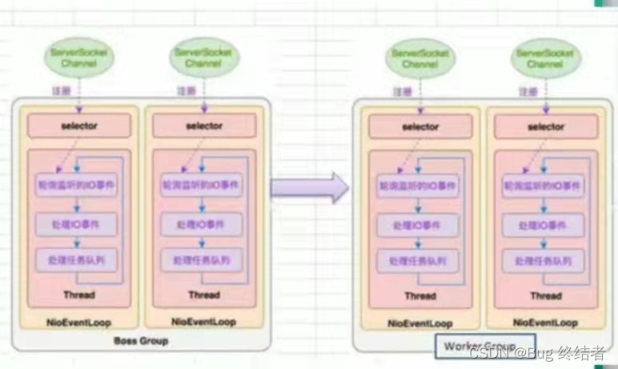

Netty 主要基于主从 Reactor 多线程模型,做了一定的改进,其中主从 Reactor 多线程模型有多个 Reactor

♨️详细版本

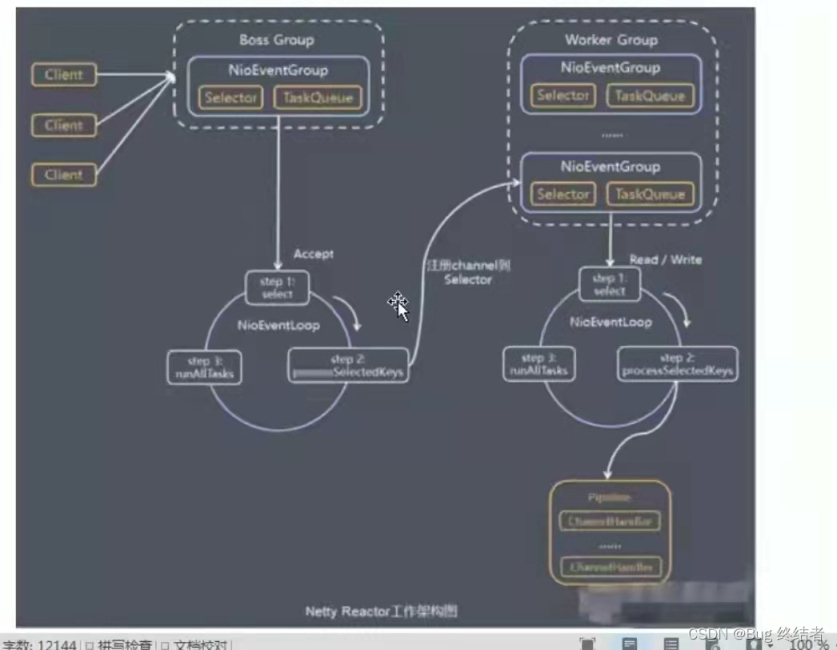

对上图的说明

-

Netty 抽象出两组线程池, BossGroup 专门负责客户端的连接,WorkerGroup 专门负责网络的读写

-

BossGroup 和 WorkerGroup 类型都是 NIOEventLoopGroup

-

NIOEventLoopGroup 相当于**一个事件循环组,**这个组中有多个事件循环,每一个事件循环是 NIOEventLoop

-

NIOEventLoop 表示一个不断循环的执行处理任务的线程,每个 NIOEventLoop 都有一个 Selector,用于监听绑定在其上的 Socket 网络通讯

-

NIOEventLoopGroup 可以有多个线程,即可以含有多个 NIOEventLoop

-

每个 Boss NIOEventLoop 循环执行的步骤有 3 步

-

轮询 accept 事件

-

处理 accept 事件,与 client 建立连接,生成 NIoSocketChannel,并将其注册到某个 Worker NIOEventLoop 上的 selector

-

处理任务队列的任务,即 runAllTasks

-

每个 Worker NIOEventLoop 循环执行的步骤

-

轮询 read,write 事件

-

处理 i/o 事件,在对应的 NIOSocketChannel 处理

-

处理任务队列的任务,即 runAllTasks

-

每个 Worker NIoEventLoop 处理业务时,会使用 pipeline(管道)pipeline 中包含了 channel,即通过了 pipelien 可以获取到对应通道,管道中维护了很多的处理器

八、Netty 入门案例 — TCP 服务

✅ 需求说明

Netty 服务器在 6666 端口监听,客户端发送消息给服务器 “Hello,服务器”

服务器可以回复消息给客户端 “hello 客户端”

✅ 效果图

✅ 核心源码

NettyServer

服务器,监听 6666 端口

NettyServerHandler

服务器处理器,处理客户端发送的消息并输出到控制台,并向服务端发送消息

NettyClient

客户端,用于连接服务器

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 |

package com.wanshi.netty.simple; import io.netty.bootstrap.Bootstrap; import io.netty.channel.ChannelFuture; import io.netty.channel.ChannelInitializer; import io.netty.channel.EventLoopGroup; import io.netty.channel.nio.NioEventLoopGroup; import io.netty.channel.socket.SocketChannel; import io.netty.channel.socket.nio.NioSocketChannel; public class NettyClient { public static void main(String[] args) throws Exception { //客户端需要一个事件循环组 EventLoopGroup eventExecutors = new NioEventLoopGroup(); try { //创建一个客户端启动对象 //客户端使用的不是ServerGroup 而是Bootstrap Bootstrap bootstrap = new Bootstrap(); //设置相关参数 bootstrap.group(eventExecutors) //设置线程组 .channel(NioSocketChannel.class) //设置客户端通道的实现类(反射) .handler(new ChannelInitializer<SocketChannel>() { @Override protected void initChannel(SocketChannel socketChannel) throws Exception { socketChannel.pipeline().addLast(new NettyClientHandler()); //加入自己的处理器 } }); System.out.println("客户端 is ok..."); //启动客户端去连接服务器端, netty异步模型ChannelFuture ChannelFuture channelFuture = bootstrap.connect("127.0.0.1", 6668).sync(); //给关闭通道进行监听 channelFuture.channel().closeFuture().sync(); } finally { //优雅关闭线程池 eventExecutors.shutdownGracefully(); } } } |

NettyClientHandler

客户端处理器,处理服务器发送的消息输出到控制台,并向服务器发送消息

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 |

package com.wanshi.netty.simple; import io.netty.buffer.ByteBuf; import io.netty.buffer.Unpooled; import io.netty.channel.ChannelHandlerContext; import io.netty.channel.ChannelInboundHandlerAdapter; import io.netty.util.CharsetUtil; public class NettyClientHandler extends ChannelInboundHandlerAdapter { /** * 当通道就绪就会触发该方法 * @param ctx * @throws Exception */ @Override public void channelActive(ChannelHandlerContext ctx) throws Exception { System.out.println("client " + ctx); ctx.writeAndFlush(Unpooled.copiedBuffer("hello,服务端Server:喵~", CharsetUtil.UTF_8)); } /** * 当通道有读取事件时,会触发 * @param ctx * @param msg * @throws Exception */ @Override public void channelRead(ChannelHandlerContext ctx, Object msg) throws Exception { //将msg转成buf ByteBuf buf = (ByteBuf) msg; System.out.println("服务器回复的消息:" + buf.toString(CharsetUtil.UTF_8)); System.out.println("服务器的地址:" + ctx.channel().remoteAddress()); } // 当通道发生异常时执行此方法 @Override public void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) throws Exception { cause.printStackTrace(); ctx.close(); } } |

from:https://xie.infoq.cn/article/d85f5bbb570ba3299137c369e?utm_source=home_write_related&utm_medium=article